電子報

現今的世代隨著AI(Artificial Intelligence)的技術蓬勃發展,近年來利用卷積神經網絡(Convolutional Neural Network,CNN)或深度學習(Deep Learning)等技術於影像辨識已成為現代常見的方式之一,進而遙測技術上也不斷與時俱進,先前幾期電子報對於各種遙測技術進行簡介及應用,如電子報第3期、第11期、第19期、第53期、第61期、第74期、第90期、第97期、第118期及第120期等。但你有沒有想過電腦的運作是怎麼樣呢?他們又是如何思考與分析圖像呢?當衛星影像受空間解析度不足而導致AI物件偵測有所限制怎麼辦呢?本期將介紹電腦影像辨識思維、影像色彩構成,最後簡單介紹衛星影像地圖測製之作業程序及超解析度成像法。

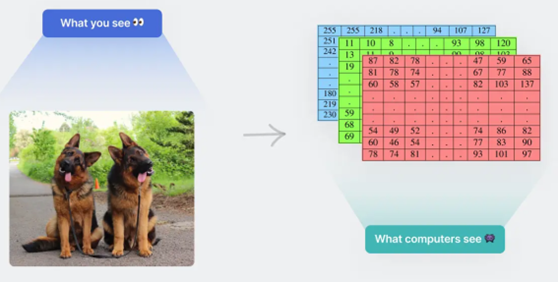

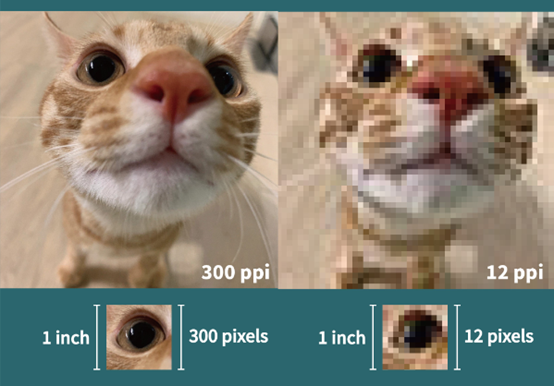

所謂影像辨識,白話來說就是將相片或由許多相片疊合成的影片透過電腦程式運算,最後進行影像處理、分析、量測與解釋出該實體有用之資訊。在電腦的眼中所有圖片都是以網格的方式進行解讀,我們將一個網格稱之為像素(pixel),這些像素的位置與色彩便組成點陣數位影像,就是常聽到的「

另一個常見的「

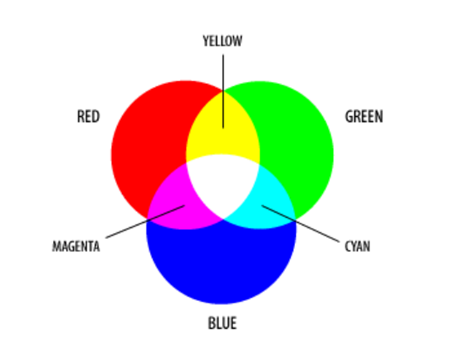

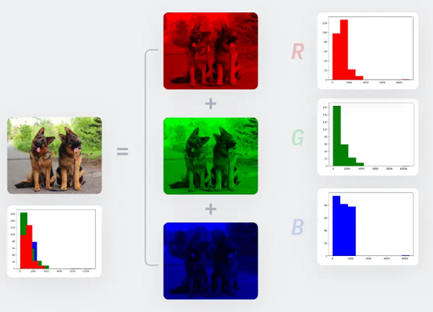

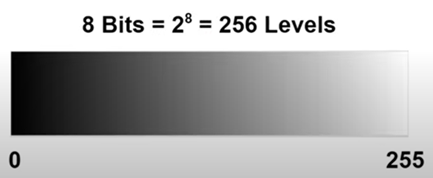

上段提到,電腦將所有圖片以網格形式解讀,那麼電腦如何呈現這些網格中的內容呢?其實,每個像素都具有明確的位置與單一的色彩,對電腦來說圖片都是由一堆的數字碼組成色彩資訊,這些色彩資訊分為兩類:黑白單色與由紅、綠、藍三原色構成的彩色RGB,並各別由不同的位元(Bits)組成(圖3)。

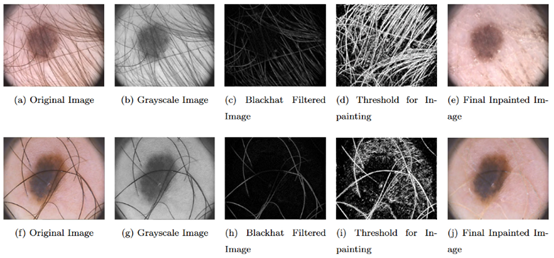

常見的單色影像如8位元的 256灰階圖像 (Gray Scale Image),而彩色影像則有256色(8位元)和全彩(24位元)等模式(東海大學資訊管理學系教材)。以常見的Python語言來說,可以藉由這些不同位元構成的影像,透過不同的函式讓電腦做出各種呈現,如:色彩轉換cvtColor、高斯模糊GaussianBlur、邊緣檢測Canny、過濾顏色範圍inRange、找輪廓findContours及輪廓面積contourArea等等,使我們的圖片做更多的處理及分析應用。更多相關內容可以參考下方影片,其內容涵蓋影像辨識、處理及人臉辨識等主題,亦展示如何利用Python opencv進行影像處理。

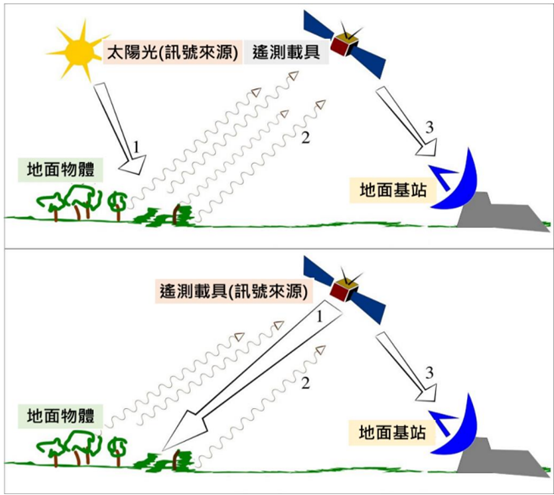

朱子豪(2009):「廣義的遙測技術是不經接觸而取得物體、地區或現象之資訊的技術」,遙測相比UAV之最大優勢在於觀測範圍大且續航時間長,如電子報第118期所述,遙測之載具,可分成由飛機搭載感測設備的空載(Airborne),及由衛星搭載感測設備的星載(spaceborne),載具可依成像方式分為主動與被動兩種。主動式成像為主動發射電磁波並接收反射回波進行成像,如微波(SAR、InSAR等)與光達(LiDAR)。被動式成像則僅接收地物反射的光來形成影像,像是相機和可見光的應用,如(Landsat 衛星、Sentinel 衛星、SPOT 衛星及福爾摩沙二號衛星等)(資料來源 :交通部運輸研究所,2023)。

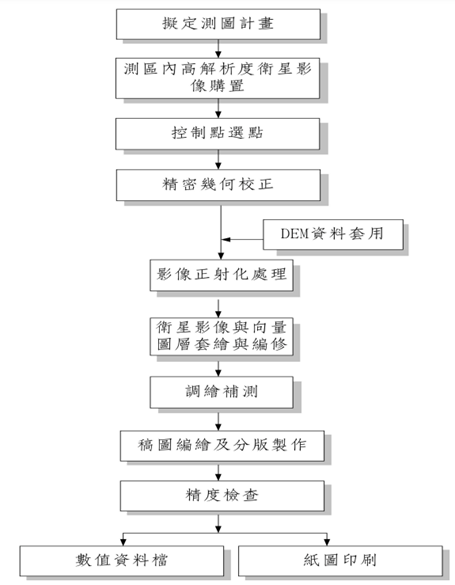

由於影像地圖係由衛星影像、影像融合、影像幾何糾正、色彩修正、向量圖層編繪及疊合等一系列作業的最後一項成果,且衛星影像之成像幾何、空間解析度、影像色彩融合、幾何糾正處理及成圖比例尺等均與傳統測量製作地圖有所差異,因此內政部近期擬定「影像地形圖測製規範_草案」,目的是將高解析度衛星影像的測製與管理業務標準化,設定基本標準,並提供製作過程中的注意事項和檢核成果是否符合標準的方法。其作業程序如下所示。(如想看更多請點我)

1. 擬定測圖計畫(測製程序)。

2. 訂購全色態及具多光譜波段高解析度衛星影像。

3. 地面控制點選取與坐標量測。

4. 影像幾何(正射)糾正、融合與鑲嵌處理。

5. 向量圖層套疊與編修。

6. 正射影像稿圖編繪與整飾。

7. 成圖精度檢查。

8. 衛星影像地圖印刷。

延續118期電子報中有詳細介紹機器學習模型建置流程可分為資料蒐集及預處理、特徵選擇,最後再利用不同演算法來建立分類模型及驗證模型,其主要分為監督式學習及非監督式學習,其兩者差異主要在於機器訓練影像時,前者為藉由透過人工標記的影像進行訓練,後者為機器藉由演算法自動尋找訓練特徵自己學習。本期將不另贅述過多相關概念,詳細細節可參閱118期電子報「表1、常見的機器學習模型」。

而林文賜於2001年及劉其輝於2005年之研究都表明,利用監督式分類方法來偵測衛星影像中物件的準確度要優於非監督式分類的物件偵測方法,而B. Nerupane等人(2021)也指出利用深度學習神經網絡偵測衛星像中的物件能力已經超越傳統的方法,表明了現今遙測的能力已經邁向更高的準確度與效率。

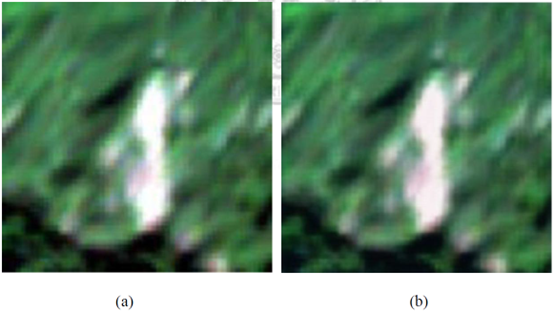

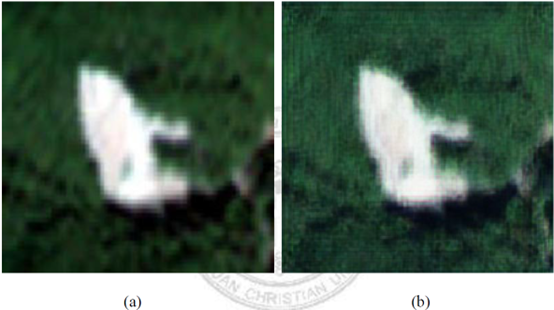

傳統來說如果取得解析度較低的衛星影像時,通常都藉由最近鄰插值(Nearest Neighbor Interpolation)、雙線性內插法(Bilinear Interpolation)以及雙立方內插法等演算法提升原始影像解析度,影像處理的案例可透過影1有教學的Python OpenCV之Resize函數,有興趣者可自行嘗試。而除了應用上述不同的方法來進行超解析度影像處理外,深度學習的方法也逐漸多人進行研究。其中,陳映融於2021年研究中利用SRResNet及SRGAN兩種不同模型之深度學習演算法來進行超解析度影像處理,兩著的典型範例結果如圖8及圖9所示,皆顯示能將原始影像像素進行提升。

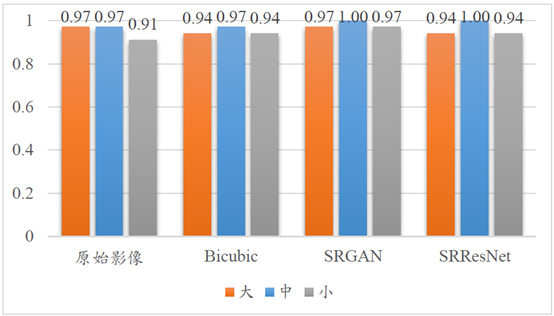

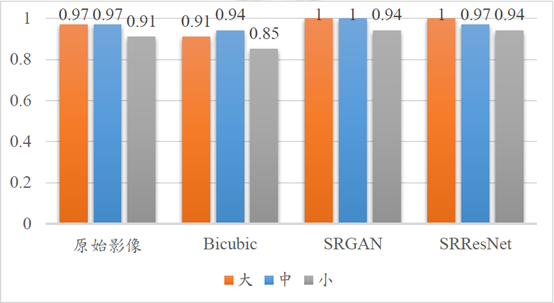

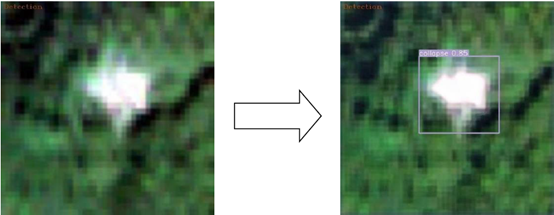

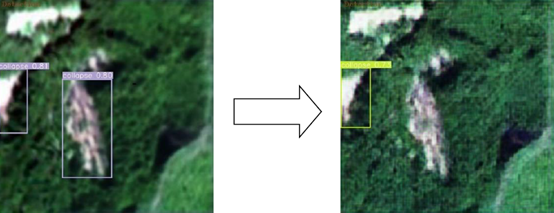

將兩種處理成果導入兩種物件辨識深度學習網路(Faster R-CNN及YOLOv51)來進行大型、中型及小型崩塌地判釋,發現原始影像分別辨識準確度由大至小是0.97、0.97及0.91,而經由超解析度影像處理後大致都能提高(如圖11、12),其提升辨識效能例子如圖13,失效辨識例子如圖14。

在利用深度學習來進行衛星影像超解析度處理時,機器會不斷地對崩塌地紋理細節及影像特徵進行學習,進一步產生具有豐富紋理細節之影像,但各模型都還有一些不足,期望在未來運算效能大幅增加且超解析度處理技術更為普及後,能夠讓遙測影像更為細緻且準確,讓臺灣災害應變及土砂災害監測預警等業務能夠更加精進及準確,提升國內水土保持防災技術。

1. 久勝旗幟官方網站文章(2022)。

2. 灣的製造官方網站(2019)。

3. Nix Color Sensor官方網站。

4. 東海大學資訊管理學系教材。

5. Rohit Kundu(2022)。Image Processing: Techniques, Types, & Applications [2024]。

6. GrandmaCan -我阿嬤都會(2022)。【python】opencv 2小時初學者教學 | 影像辨識 | 影像處理 | 人臉辨識 | 電腦視覺。

7. 交通部運輸研究所(2023)。多期多尺度影像結合深度學習於邊坡地貌變異判識之初探(1/2)-影像蒐集及辨識演算法架構探討。

8. 內政部影像地形圖測製規範_草案。

9. 林文賜(2001)。應用監督性類神經網路於衛星影像分類技術探討。航測及遙測學刊第六卷第一期。

10. 劉其輝(2005)。結合遙測與地理資訊系統於都市發展之研究-以桃園縣(復興鄉除外)為例。國立政治大學地政學系碩士論文。

11. R. Keys, "Cubic Convolution Interpolation for Digital Image Processing," IEEE Transactions on Acoustics, Speech, and Signal Processing, 29(6), pp. 1153-1160, Dec. 1981.

12. B. Nerupane, T. Horanont, and J. Aryal, “Deep Learning-Based Semantic Segmentation of Urban Features in Satellite Images: A Review and Meta-Analysis," Remote Sens, 13(4), pp. 1-41, Feb. 2021.

13. 陳映融(2021),利用超解析度成像技術提升衛星影像中崩塌物件辨識的效能。中原大學電子工程學系碩士論文。